ChatGPT heeft ongewild conversaties van andere gebruikers opgeslagen in de conversatiegeschiedenis van een gebruiker. Het lek zou zijn ontstaan door een account-overname, stelt OpenAI. Dit vormt een veiligheidsprobleem voor andere gebruikers, aangezien onder meer wachtwoorden werden gelekt. Het lek werd bekendgemaakt door de gebruiker aan de redactie van Ars Technica.

Update 31-01 (Erik van Klinken): Inmiddels is bekend dat de data volgens OpenAI lekte omdat een account was overgenomen. Dit nieuwsbericht is van een update voorzien om dit feit toe te voegen.

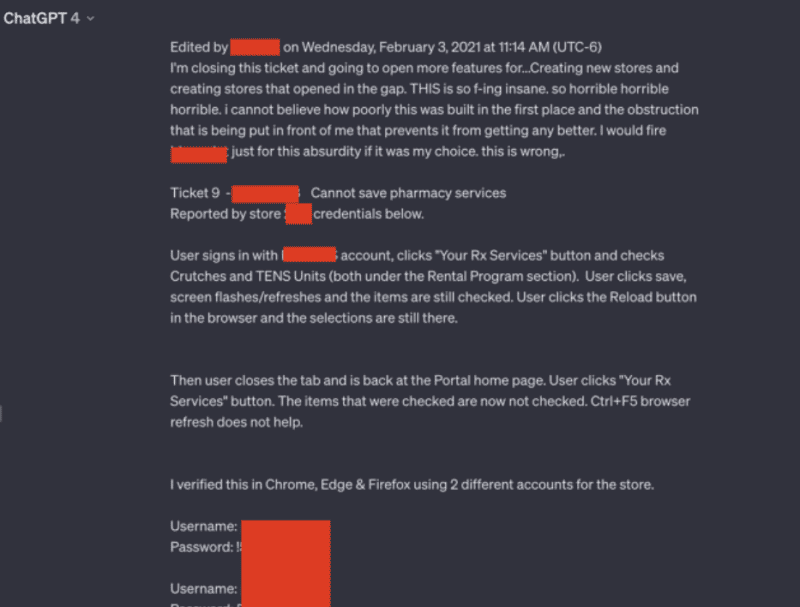

Ars Technica kreeg naar eigen zeggen van een lezer screenshots waarin duidelijk werd dat ChatGPT ongevraagd conversaties van andere eindgebruikers in diens conversatie-geschiedenis plaatsten. De conversaties waren volledig zichtbaar en bleken een groot aantal login credentials en andere persoonlijke details van gebruikers bij te houden, die niet met dit incident te maken hebben.

Meer specifiek ging het om gebruikersnamen en wachtwoorden die in een ondersteuningssysteem stonden waaraan op dat moment werd gesleuteld. Een medewerker van het betreffende bedrijf zou hierbij de AI-chatbot gebruiken om deze problemen op te lossen.

Daarnaast verschenen bij de betreffende eindgebruiker in zijn conversatiegeschiedenis ook conversaties over een opgezette presentatie, details van nog niet gepubliceerd onderzoek en een PHP-script.

OpenAI points to account takeover

OpenAI has now told Ars Technica that an account takeover caused the compromised account to leak the data. The unwanted chat messages were sent from Sri Lanka shortly after a successful log-in from that country. The legitimate user has since changed the password.

Eerdere incidenten

Het is niet de eerste keer dat een dergelijke fout zich bij ChatGPT voordoet. In maart 2023 legde OpenAI zijn AI-chatbot al stil omdat een bug ervoor zorgde dat titels van de chatgeschiedenis van een actieve gebruiker bij andere niet-gerelateerde eindgebruikers zichtbaar werden. Dit incident wijkt daarvan af omdat het een gecompromitteerd account betrof. Wel ontbreken er genoeg middelen voor gebruikers om dergelijke overnames te voorkomen, zoals MFA en het controleren op IP-locatie.

In november 2023 ontdekten onderzoekers dat zij met prompts in ChatGPT in staat waren om e-mailadressen, telefoon- en faxnummers, fysieke adressen en andere privégegevens te schrapen uit data die voor het trainen van het onderliggende LLM waren gebruikt.

Probleem zo oud als het internet

Volgens onderzoekers is het opduiken van data van gebruikers in andere accounts zo oud als het internet zelf. Dit zou vooral komen door het gebruik van zogenoemde ‘middleboxes’. Deze bevinden zich tussen de front- en back-end devices en cachen data voor betere prestaties. Inclusief de inloggegevens van gebruikers die zijn ingelogd. Bij mismatches kan het voorkomen dat dan de inloggegevens van de ene account worden doorgezet naar een andere account.

OpenAI geeft aan het recente incident rondom het opduiken van een andere chatgeschiedenis te onderzoeken.

Lees ook: ‘ChatGPT maakt vooral onveilige code’