Een van de belangrijkste knelpunten voor generatieve AI is de omgang met data. Hoe zorg je als bedrijf ervoor dat je van AI kunt profiteren, maar zonder je bedrijfsdata prijs te geven? VMware en Nvidia hebben daarvoor de handen ineengeslagen en komen met de zogeheten Private AI Foundation. Ook werkt VMware samen met AI-bedrijven om een open ecosysteem voor de technologie aan te moedigen.

VMware en Nvidia zijn geen vreemdelingen van elkaar: hun samenwerking is alweer tien jaar bezig. Samen hebben ze geïnnoveerd op het gebied van grafische simulatietechnieken, HPC-oplossingen en trainingsmethodes voor machine learning. Nu timmert men aan de weg van generatieve AI, iets waar de gehele tech-industrie inmiddels wel bekend mee is. Toch is er ondanks alle ontwikkelingen op dit gebied nog steeds een vraagstuk onbeantwoord: hoe zet je als bedrijf je data veilig in terwijl je de potentie van AI waar maakt?

Het nut van AI is duidelijk, maar hoe pas je het zorgvuldig toe?

Een kenmerkend aspect van generatieve AI is dat de specifieke toepassing ervan enorm kan verschillen per bedrijf. Financiële instellingen kunnen ermee fraude opsporen, maar het kan ook allerlei systemen van moleculaire structuren tot fabrieken simuleren. De bekendste toepassing is wellicht de inzet van AI-assistenten die programmeercode, inzichten over klantgedrag of vrij zinvolle tekst kunnen genereren. VP Enterprise Computing bij Nvidia Justin Boitano haalt onderzoek aan van Accenture dat aangeeft hoe veelbelovend AI is voor bedrijven. Daar stelt men dat een groot bedrijf 2,6 keer zoveel kans maakt om 10 procent meer omzet te halen als het AI zorgvuldig wordt toegepast. Boitano spreekt over een vertienvoudiging van onze productiviteit waar elk bedrijf in theorie van kan profiteren. Maar daar ligt natuurlijk de crux: hoe doe je dat?

Vice President Product Management vSphere bij VMware Paul Turner benoemt de troef die bedrijven daarvoor in handen hebben: hun eigen data. Als het goed is, hebben organisaties de eigen gegevens veiliggesteld en op een rijtje. Generatieve AI kan deze informatie samenvoegen en transformeren tot nuttige inzichten, zoals de eerder genoemde voorbeelden. De technologie klinkt soms wollig, maar Turner vat het nut ervan voor zijn eigen werkgever als volgt samen: “Binnen VMware nemen we onze code-mogelijkheden, onze API’s en al onze interfaces om code samples voor je te genereren. Als je een VM wil migreren binnen je omgeving, kunnen we de code sample daarvoor automatisch creëren. Daarnaast brengen we onze kennisbank samen op basis van 25 jaar aan artikelen om automatische antwoorden voor klantondersteuning te genereren. Alle bedrijven kunnen zoiets doen.”

De keuze voor bedrijven: public of private

Binnen de public cloud zijn er genoeg voordelen te benoemen. De schaalbaarheid van een extern datacenter en 24/7-beschikbaarheid zijn erg aanlokkelijk. Ook is het onvoorstelbaar om een AI-model van het formaat van een GPT-3 of GPT-3.5 op eigen infrastructuur te draaien, laat staan GPT-4. Toch raadt VMware dit plan van aanpak af. De bedrijfsdata is richting een public cloud verstuurd, met het gevaar dat iemand deze gegevens weet te stelen. Ook is bij veel modellen op de public cloud niet vast te stellen op welke data ze getraind zijn, waardoor de output moeilijk te controleren of na te gaan is.

Kortom: er is een andere oplossing nodig. Je kunt het als organisatie niet allemaal alleen regelen en je wilt jezelf niet blootstellen aan de gevaren van public cloud. Turner benoemt het LLaMA 2-model van Meta, die publiekelijk beschikbaar is. Je kunt dit model on-prem nemen, (bijvoorbeeld de 70B-variant, oftewel met 70 miljard parameters) voeden met eigen bedrijfsdata en zo tot een werkbare oplossing komen. “Zet je data in voor die modellen en verfijn ze daarmee. Wat je in feite doet, is de smaak van jouw data toevoegen om het te transformeren tot iets waar je echte waarde uit haalt.” Samen met Nvidia belooft Turner dat VMware dit voordelig en eenvoudig kan klaarspelen.

Een kant-en-klaar pakket

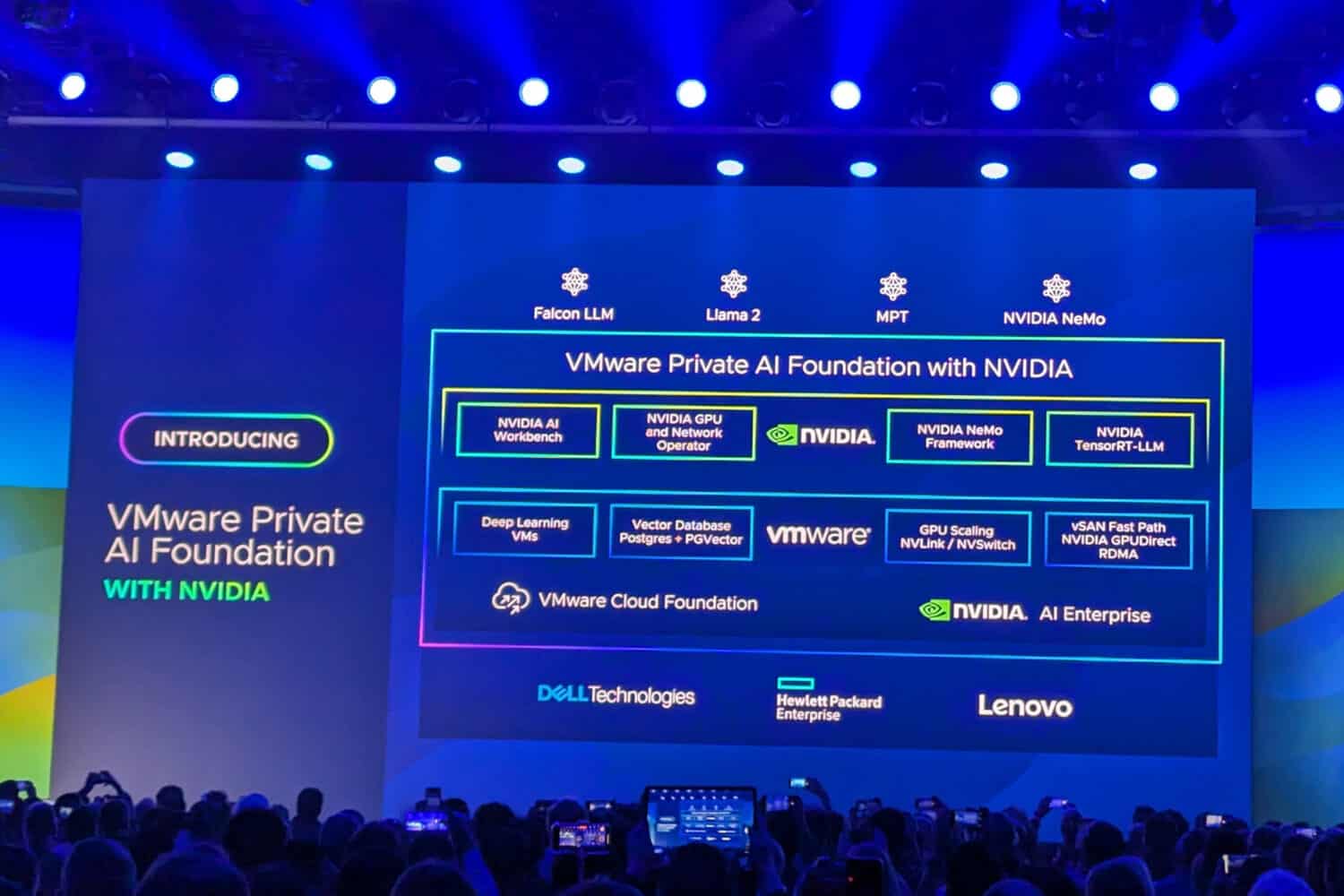

Bedrijven hebben logischerwijs vaak geen idee waar ze moeten beginnen als het om AI gaat. Om die reden houden VMware en Nvidia er een platformbenadering op na. Ze hebben een infrastructuur bedacht die zo benaderbaar mogelijk is: bedrijven die al VMware’s cloud-infrastructuur inzetten kunnen er snel gebruik van maken. Ook belooft men gebruik te maken van de beste technologieën die momenteel beschikbaar zijn.

Vanuit Nvidia kunnen klanten gebruikmaken van de Nvidia AI Workbench en NeMo Framework om AI-modellen te verfijnen naar wens. Daarop haakt het aanbod van VMware in: het heeft specifieke kant-en-klare VM-images ontwikkeld die geschikt zijn voor deep learning. Essentieel daarbij is de Vector Database, die nodig is om AI-inferencing te doen (oftewel de voorspellende capaciteiten van AI op basis van bestaande data).

Niet elke AI-workload is dezelfde en lang niet elk bedrijf heeft data even snel nodig. Daarom is deze Private AI-oplossing schaalbaar, met vSphere-VM’s die maximaal 16 GPU’s kunnen inzetten. Ze zijn verbonden met elkaar via het extreem snelle NVLink en kunnen direct vanuit NVMe-opslag aangesproken worden zonder nog langs de CPU of andere componenten te gaan. Dit is zelfs mogelijk van server naar server, waardoor latency geminimaliseerd wordt. Het gaat hier om de Nvidia L40S, een grafische kaart die slechts twee weken geleden werd aangekondigd. Elke GPU heeft 48GB aan videogeheugen. Om een model als LLaMA 2 van Meta in real-time te draaien, is bijvoorbeeld 140GB nodig en dus een minimum van vier samenwerkende GPU’s. Er zijn hiernaast genoeg alternatieven, die variëren van grotere tot veel kleinere modellen, en daarom is deze schaalbaarheid erg nuttig.

Levering via partners, dan aan de slag

Om dit alles te draaien, is meer nodig dan software van VMware en Nvidia en een aantal imposante GPU’s. De leveranciers voor datacenters Dell, HPE en Lenovo kunnen full-stack platforms bouwen die geschikt zijn voor generatieve AI. Het gaat hier om nieuwe, geoptimaliseerde systemen die binnen serverracks te plaatsen zijn. Het is ook mogelijk als klant om enkel de software te ontvangen en zelf systemen te bouwen.

Dit alles betekent dat bedrijven volgens Boitano al beginnen met 95 procent van het werk dat al gereed is. Wat resteert is het aanleveren van eigen data die per bedrijf verschilt om ervoor te zorgen dat de gekozen LLM je bij kunt staan voor de gewenste taak. Door de geleverde software zou alles eenvoudig aan te passen zijn naar wens om dit stapsgewijs te bereiken. Het eindresultaat is een “nieuw model met een genuanceerd begrip van de eigen bedrijfsgegevens die privé blijven,” aldus Boitano. “Het staat migratie met één klik toe van laptop of pc naar het datacenter toe. Daar zal het merendeel van de werkzaamheid van large language models plaatsvinden.” Het fine-tunen van een LLM van 40 miljard parameters kan door 8 L40S-GPU’s binnen 8 uur voltooid zijn. Vervolgens zorgt de software van Nvidia ervoor dat het inzetten van deze AI-modellen zo efficiënt mogelijk verloopt.

VMware en Nvidia beloven met de Private AI Foundation een werkbare, relatief eenvoudige oplossing voor het draaien van generatieve AI binnen de bedrijfsmuren. Stapsgewijs kunnen klanten de inzet van AI realiseren zonder extra vrees voor datalekken of frustraties over oncontroleerbare modellen. Wel is het nog even wachten: Private AI Foundation zou begin 2024 moeten verschijnen.

Een open ecosysteem

VMware heeft naast Nvidia nog een aantal andere AI-gerichte bedrijven als partner te pakken. Het vat het systeem van partner-oplossingen en eigen applicaties samen als de Private AI Reference Architecture. Zo heeft het binnen VMware Cloud Foundation de Ray “unified compute framework” toegepast voor het optimaliseren van compute-footprints. Ook partnert Domino Data Lab met VMware en Nvidia om een gespecialiseerd AI-platform te bieden voor financiële instellingen. Hugging Face biedt een programmeercode-assistent die VMware zelf eveneens intern gebruikt; laatstgenoemde publiceert daarom een voorbeeld voor klanten van hoe deze AI-tool zo snel mogelijk te draaien is binnen de bestaande VMware-infrastructuur. Ten slotte haalt VMware Intel aan: de 4e generatie Xeon-processoren bevatten AI-accelerators die binnen VMware vSphere/vSAN 8 en Tanzu optimaal benut dienen te zijn.

Tijdens VMware Explore in Las Vegas zullen er de komende dagen showcases zijn van deze innovaties. Ook hebben we al een overzicht gepubliceerd van de modernisering die VMware binnen de eigen Cloud Foundation heeft toegepast.

Lees dat artikel hier: VMware Cloud weer up-to-date met NSX+, vSAN Max en betere security