Intel streeft naar een wereld waarin AI-compute overal beschikbaar is. Dat begint bij de datacenter, met de 5e generatie Intel Xeon als kloppende hart. Toch biedt de nieuwe serverchip voor iedereen wat wils, met lagere kosten voor klanten dankzij een aanzienlijke efficiëntiewinst.

CPU’s zoals de Intel Xeon en AMD Epyc spelen een sleutelrol in de wereldwijde IT-infrastructuur. Zelfs als partijen hun eigen acceleratoren bouwen, zoals AWS met de Graviton en Trainium, zijn ze nog altijd afhankelijk van een processor die een servercluster aanstuurt. “Als er een accelerator is, heeft het een host-CPU nodig,” laat Marc Sauter weten, EMEA Technology Communications Manager for Enterprise bij Intel.

Ook voor AI-workloads is de CPU cruciaal, stelt Sauter. Hij stipt aan dat zelfs Nvidia-CEO Jensen Huang koos voor de 4e generatie Xeons bij de DGX H100, dat Nvidia zelf omschrijft als de “gouden standaard voor AI-infrastructuur”. Sauter schrijft deze keuze van Huang toe aan de ongeëvenaarde single-threaded prestaties van de Intel-CPU. Xeons zijn eigenlijk de stille kracht achter de AI-revolutie, zelfs als het niet alle aandacht (en de gunstige beurskoers) ontvangt. Daarnaast zouden kleine en middelgrote AI-modellen gewoon geschikt zijn om te fine-tunen en te draaien op Xeons, terwijl GPU’s enkel als zwaar geschut ingezet hoeven te worden bij een bijzonder grote LLM als Meta’s Llama 70B of OpenAI’s GPT-4. Voor een vlugge AI-training op de dataset zul je toch wel echt bij Nvidia moeten aankloppen (en dan nog duurt het weken).

“De beste CPU voor AI”

Bij de presentatie van de nieuwe 5e generatie Xeons windt Intel er geen doekjes om: “de beste CPU voor AI, hands down“. Daarin speelt de processor niet enkel de tweede viool achter de felbegeerde AI-vaardige GPU’s. De Sapphire Rapids-architectuur van de vorige generatie Xeons was al in grote mate gericht op specifieke workloads, waaronder AI. Voor dat doeleinde maakt het gebruik van speciale acceleratoren, ingebakken componenten in de CPU die uitermate geschikt zijn voor selecte taken. Het is een duidelijk andere aanpak dan die van AMD, waarbij de serverchips Genoa en Bergamo vooral ongekende aantallen cores bevatten. Volgens Sauter is dat vanaf een bepaald moment niet meer rendabel: extra prestaties kosten dan simpelweg onevenredig veel energie, iets dat onder de streep hard wordt afgestraft. Efficiëntie én prestaties zijn dus belangrijk. “Wij willen het beste van beide werelden,” stelt Sauter. Ook blijkt uit IDC-onderzoek dat de meest ingezette oplossingen gebruikmaken van een ‘midrange’ aantal cores, dus eerder 16 of 32 dan 64, 96 of zelfs 128 cores.

Emerald Rapids, de architectuur achter de 5e generatie Xeons, borduurt voort op deze filosofie. Wel is het aantal tiles, discrete stukjes silicium waaruit een enkele processor gebouwd is, gehalveerd. In plaats van vier tiles zijn er nu twee, dat allerlei technische voordelen met zich meebrengt. Onder de streep levert de nieuwe architectuur maximaal 4 extra cores op (naar 64) over de gehele chip, terwijl er eveneens grote efficiëntieverbeteringen te zien zijn.

De grootste prestatiewinsten ten opzichte van Gen 4 zijn de hogere throughput (+70 procent) van networking en storage en de snellere AI-inferencing (+42 procent). Een verdriedubbeling van de L3-cache is hierin een belangrijke factor. Dit terwijl eigenaren van bestaande 4e generatie Xeon-platformen de nieuwe processor met een drop-in upgrade kunnen installeren. Echter kan dat niet als men 8 sockets wil vullen in één systeem, een zeldzaam scenario.

Wie is de klant?

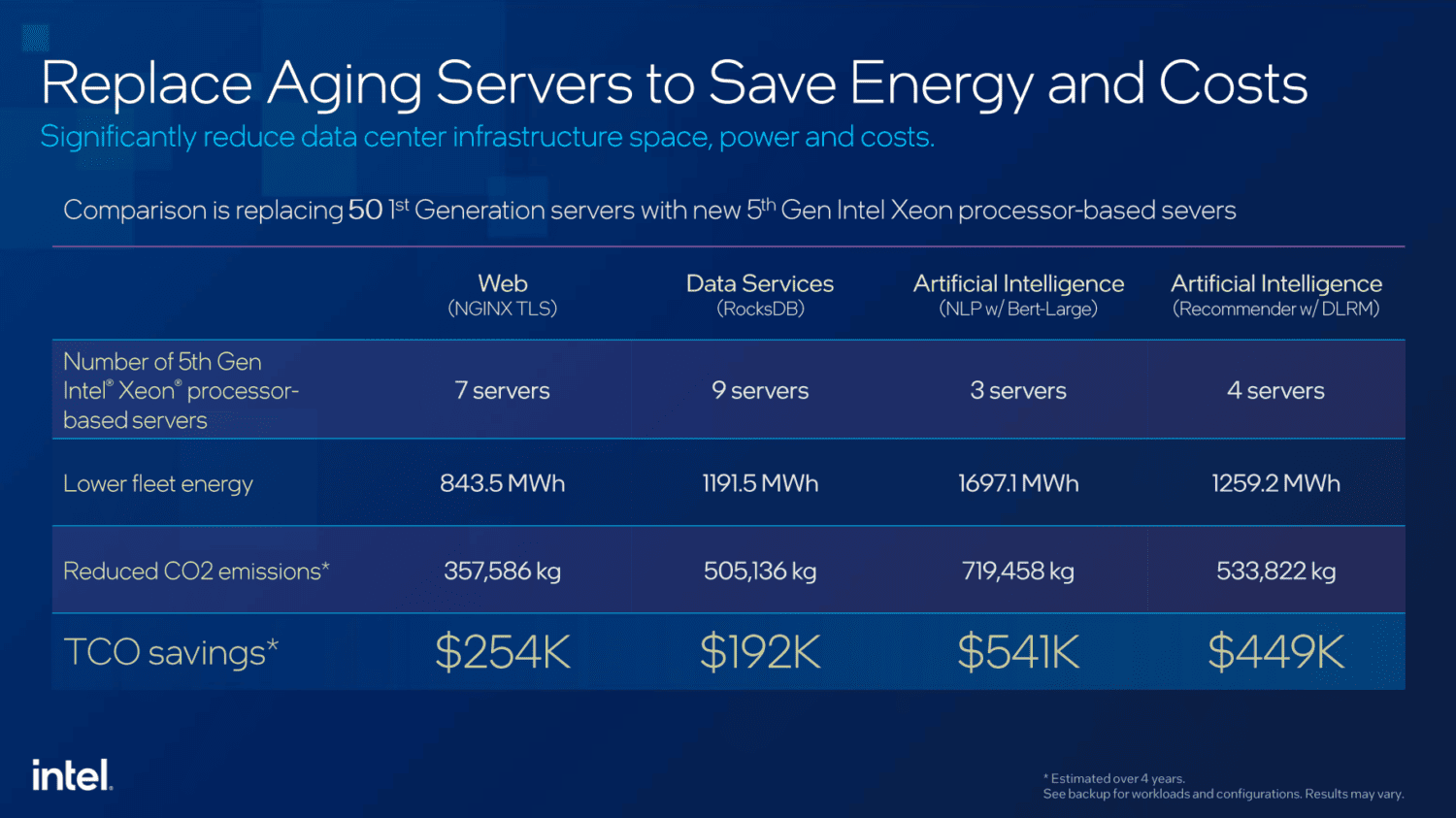

Sauter geeft aan dat de meerderheid van Xeon-bezitters nog gebruikmaken van chips uit de 1e en 2e generatie. Xeon generatie 2, in april 2019 gelanceerd, is de meest voorkomende van alle series. Aangezien de gewoonlijke upgrade-cyclus voor serverchips volgens Sauter gewoonlijk drie à vier jaar is, zal Gen 5 voor velen een instapmoment zijn. Dan hebben we het niet over de allergrootste spelers op de markt, want die upgraden elk jaar. Voor de rest van het Xeon-klantenbestand zou het mogelijk nu wel tijd zijn om in het nieuwe platform te stappen. Hen staat een aardig voordelig kostenplaatje te wachten, als we Intel mogen geloven:

Intel blijft op TCO (Total Cost of Ownership) hameren, ook als het de nieuwste chips vergelijkt met Xeon’s 3e generatie. Ten opzichte van AMD liegen de cijfers er niet om: grofweg 30 Intel Xeon-servers zouden de strijd aan kunnen met 50 AMD EPYC 9554-servers, terwijl die strijd met AI-workloads nog ongelijker wordt. Wie zich enkel op AI concentreert, zou namelijk al met 15 Intel-servers opgewassen zijn tegen diezelfde 50 AMD-chips. Daarbovenop komt dan nog een kostenbesparing van 62 procent in het meest extreme geval, bekeken over een tijdsbestek van vier jaar. Voor het draaien van web- of datadiensten en HPC-workloads besparen klanten met de nieuwste Xeon volgens Intel tussen de 21 en 27 procent in vier jaar tijd.

De blik gaat alweer vooruit

We weten al dat het niet lang bij de Emerald Rapids-architectuur zal blijven. Granite Rapids, de codenaam voor de 6e generatie Xeons, zal drie keer zoveel geheugenbandbreedte bevatten. Tegelijkertijd staat er een verdrievoudiging van de AI-prestaties te wachten, laat Sauter weten. Ook herinnert hij ons eraan dat deze chips een ontwikkeltijd kennen van circa drie à vier jaar. Met andere woorden: de AI-revolutie van 2023 heeft Intel niet kunnen anticiperen, maar men was al lang en breed bezig met acceleratoren voor deze inmiddels opgehypte workload. Sauter verwijst naar Knights Mill, een Xeon Phi-product uit 2017 gericht op deep learning, om aan te geven dat Intel al lang aan de AI-weg getimmerd heeft. “Het laatste decennium is Intel al een AI-bedrijf.”

Voor nu en de nabije toekomst: continuous computing

Een opvallend concept tijdens Intels onthullingen is dat van ‘continuous computing’. Het houdt in dat er in datacentra, de edge en bij de client allemaal AI-hardware gereed is binnen het Intel-portfolio. Deze ‘hybrid-aanpak’ zal steeds populairder worden, meent Sauter. Een ontwikkelaar kan dankzij open toolkits als OpenVINO hun AI-applicatie ontwikkelen, terwijl Intel achter de schermen bepaalt welke hardware beschikbaar is om het op te draaien. Zoveel mogelijk taken worden dus op den duur verplaatst naar de meest efficiënte plek mogelijk, dat op den duur in potentie steeds meer bij de client ligt. Met andere woorden: AI draaien doen we over x aantal jaar vooral thuis. Dat zal ook nodig zijn, gezien de strenge privacy-eisen voor persoonlijke data die met name de Europese Unie erop nahoudt.

Althans, dat is de suggestie die de gelijktijdige aankondiging van Intel’s Core Ultra-laptopchips doet vermoeden. Het bedrijf heeft meer dan 100 software-partijen aangemoedigd om AI-aangejaagde applicaties te ontwikkelen die (deels) lokaal te draaien zijn op de gloednieuwe NPU’s (Neural Processing Units) in de komende generatie laptops. Echter blijkt uit ons gesprek met Sauter dat de zwaardere AI-taken nog wel een tijdje elders geregeld worden. Immers staat AI-hardware op laptops nog in de kinderschoenen (of, sterker nog, het is nog niet eens echt geboren). Hij zegt het niet expliciet, maar de inzet van Intel lijkt toch echt om de AI-revolutie vooral via datacentra mogelijk te maken.

Lees ook: Intel Core Ultra: de belofte van de gepersonaliseerde AI-pc