Datacenters worden alleen maar belangrijker. De continu toenemende digitalisering betekent dat organisaties afhankelijker worden van externe hardware om te functioneren. Nu zorgt de AI-hype voor een motief om fors te investeren in de vernieuwing van de datacenter-infrastructuur. Nvidia-CEO Jensen Huang spreekt over hardware ter waarde van 1 biljoen dollar (circa 936 miljard euro) die wereldwijd op de schop moet. Heeft hij gelijk?

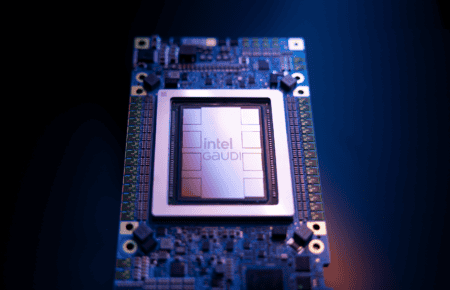

“De computer-industrie maakt twee simultane transities mee: accelerated computing en generatieve AI,” weet Huang. Er zijn dan ook meer dan genoeg redenen die je kunt bedenken om voor gloednieuwe AI-accelererende hardware te kiezen. Wie het geld beschikbaar heeft, kan kiezen om bijvoorbeeld honderdduizenden euro’s te investeren in een vloot aan Nvidia H100-GPU’s. Deze apparatuur zou tot wel dertig maal zo snel generatieve AI-modellen kunnen accelereren ten opzichte van de voorgangers binnen het Nvidia-ecosysteem. Tijd is geld, zeker als het gaat om datacenter-cycli. Op den duur zorgt de extra efficiëntie ook voor een mogelijke kostenbesparing. Wie over de houdbaarheid van deze voortdurende verbetering twijfelt, zal zich in ieder geval ook versterkt voelen door de opborrelende concurrentie. Het zal nog even duren, maar Intel is een voorbeeld van een chipbedrijf die van koers is gewijzigd omdat de AI-hype zo is gegroeid.

Nu kunnen we het verkooppraatje van Nvidia wel verwachten. Als marktleider kan het rekenen op een immense vraag naar de eigen AI-chips. Echter schreven we gisteren al over de beperkte houdbaarheid van de aanlevering van de allernieuwste chips. Een investering in nieuwe hardware wordt voor datacenterbeheerders alleen maar duurder. Daarnaast zijn er externe factoren die de idyllische voorstelling van zaken bij Huang tegenspreken.

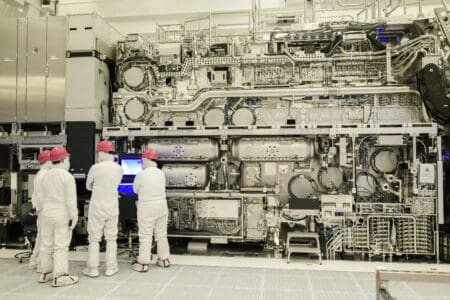

Energie, stroom, klimaat

Niemand minder dan Ampere-stichter en voormalig Intel-president Renée James luidde onlangs de noodklok over de AI-hype bij datacenters. Tegenover Bloomberg liet ze weten dat de huidige toepassing van AI-hardware veel te veel energie opslokt om houdbaar te zijn. We dienen bij deze opmerking niet te vergeten dat James zelf ook een product te verkopen heeft: Ampere-processoren. Deze op Arm-technologie gebaseerde chips zijn efficiënter dan hun x86-tegenhangers. Echter blijft haar punt overeind staan: we kunnen niet eindeloos energie afstaan aan reusachtige datacenters.

Dit probleem is zeker niet nieuw. In september 2022 brachten we al een podcast-aflevering over de mogelijke toekomst van datacenters op de zeebodem. Problemen zorgen dus voor de noodzaak om te innoveren en slimmer om te gaan met de beschikbare middelen. De torenhoge inflatie en energiekosten van de afgelopen maanden heeft geleid tot een mogelijke doorberekening naar de klant. Het stroomnetwerk is al overbelast, dus zomaar extra hardware ertegenaan gooien zal niet mogelijk zijn in Nederland. Bovenal werpt klimaatverandering een lange schaduw over deze kwestie, zoals het dat overal eigenlijk doet.

Slimmer werken, is snelheid wel echt nodig?

De Nvidia-CEO kan natuurlijk niet rekening houden met lokaal afwisselende thema’s zoals energiekosten, de belasting van het stroomnetwerk en inflatie. Echter weten andere CEO’s binnen de AI-arena dat we niet permanent door kunnen groeien. AI-modellen zijn volgens OpenAI-topman Sam Altman zowat klaar met het uitbreiden van parameters, waardoor uiteindelijk de benodigde rekenkracht binnen de perken zal blijven. Het zal zaak zijn om verbetering te zoeken door slimmer te werken.

Dit geldt niet alleen voor de ontwikkelaars van generatieve AI-modellen. Voor datacenters is dit eveneens een waarheid als een koe. Meer efficiëntie kan bereikt worden op andere wijzen dan het switchen van hardware. Huang verkoopt graag chips, maar hij zal niet de eerste zijn om andere verbeteringen voorrang te geven. DataCenter Knowledge sprak met AI-analist bij Omdia Bradley Shimmin, die de uitspraken van de Nvidia-CEO enigszins in twijfel trok. Hij zei: “Er is een andere trend gaande [dan de investering in nieuwe AI-hardware, red.] waarbij onderzoekers leren om te gaan met kleinere modellen met minder parameters, sterk gecureerde datasets en slimmere training en fine-tuning door het gebruik van PEFT en LoRa, bijvoorbeeld.” Deze twee genoemde technieken verkleinen de hoeveelheid van benodigde parameters voor AI-modellen. Daarnaast is het zo dat lang niet alle toepassingen een hypersnelle AI-toepassing vereisen. Veel bedrijven zullen uit de voeten kunnen met een ietwat compacte vorm van AI of er spaarzaam gebruik van maken.

Dit gaat dan specifiek over de efficiëntie AI-applicaties zelf, maar voor datacenters zelf valt er genoeg te winnen op dit gebied. Frappant is dat we vóór de ChatGPT-geïnspireerde AI-hype al het onderwerp van AI in een andere vorm voorbij zagen komen omtrent datacenters. Execute VP van AI-onderzoeksbedrijf Nnaisense Ralf Haller benoemde medio 2022 een aantal mogelijkheden van de technologie om de kosten van datacenters te drukken. AI kan datacenters immers optimaliseren qua energieverbruik, om een voorbeeld te noemen. Haller raadde aan om een datacenter als een compleet systeem te zien en dat te optimaliseren.

Geduld

Ten slotte kunnen we niet negeren dat politieke instanties met AI-wetten bezig zijn. China, de EU en de VS hebben allemaal initiatieven op tafel die het gebruik van AI gaan reguleren. Denk aan het beperken van de inzet van gebruikersgegevens voor verbetering van large language models of het waarborgen van kopieerrechten bij datasets. Dergelijke initiatieven betekenen dat je als datacenterbeheerder niet gelijk met de pinpas naar Nvidia hoeft te lopen. Immers kan het zo zijn dat regelgeving de continue groei van AI-toepassingen in het bedrijfsleven aan banden legt. Op korte termijn kan de AI-hype voor een FOMO (fear of missing out) bij bedrijven zorgen, mede omdat de prijzen alleen maar lijken te gaan stijgen voor de meest felbegeerde AI-chips. Echter kan het zo zijn dat geduld een schone zaak is. Wie wacht, kan immers net zo goed op een later tijdstip instappen in AI-hardware. Tegen die tijd heeft Nvidia vast weer een nieuwe chip klaarstaan die aanzienlijk efficiënter en krachtiger te werk gaat.