AMD zit Intel op de hielen met Epyc-CPU’s. Het daagt Nvidia als enige GPU-speler echt uit met Instinct. Maar networking, de nieuwste favoriete hobby van de chipmaker, vereist een andere aanpak. In dit territorium moet samenwerking juist de sleutel naar succes zijn.

“De enige manier om aan de vraag te voldoen, is om te groeien op elk front.” Die conclusie trekt Soni Jiandani, SVP & GM Network Technology Solutions Group bij AMD. Hij doelt hierbij op het feit dat AMD verder moet denken dan de CPU’s en GPU’s waar het bekend mee is geworden. Tijdens het eigen Advancing AI-evenement te San Francisco is networking opvallend prominent in het AMD-verhaal. Sterker nog: het is onmisbaar.

Lees ook: Stortvloed aan nieuwe AMD-producten: Epyc, Instinct, Ryzen en meer

De “derde pilaar”

Dit horen we van Forrest Norrod, EVP & GM van de Datacenter Solutions Group binnen AMD. Hij legt uit hoe zijn bedrijf naar diens huidige positie op de datacentermarkt kijkt, en dat is tegenwoordig een breder verhaal dan ooit. Met Epyc, het bonsende compute-hart, is AMD vanuit “virtually zero” marktaandeel gegaan in 2017 tot 34 procent van de totale omzet binnen het segment. Dit ten koste van Intel, wiens problemen we al uitvoerig hebben omschreven. Met de nieuwste vijfde generatie Epyc gaat het de strijd aan met Xeon 6, waarin AMD belooft beter uit de verf te komen in de benchmarks die ertoe doen.

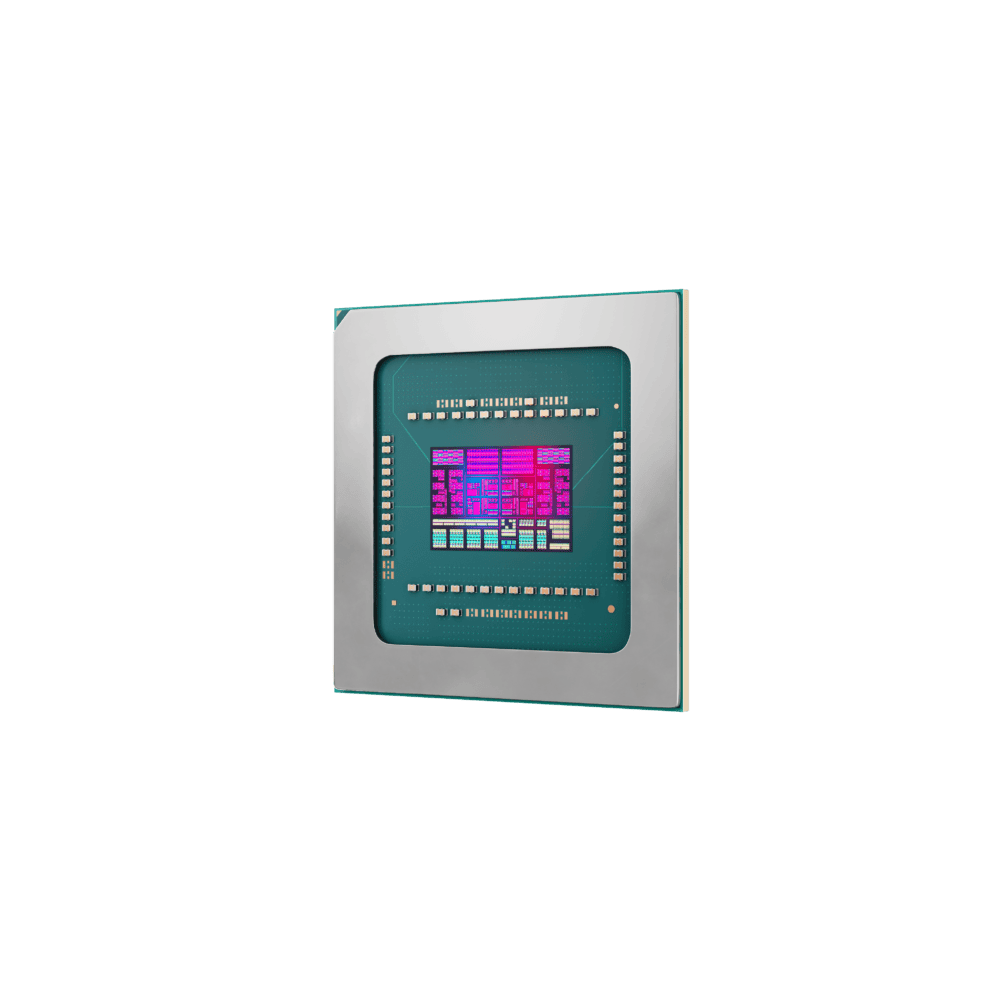

De volgende AMD-rivaal is Nvidia gebleken. Die partij is, zoals elke gretige investeerder doorheeft, een stuk lastiger te verslaan. Sterker nog, het is oppermachtig als het gaat om datacenter-GPU’s, met een marktaandeel van net niet 100 procent. Desondanks behaalde AMD 115 procent omzetgroei in de datacenterwereld het afgelopen kwartaal, iets dat het naar eigen zeggen vooral aan de ramp (Engels uitgesproken) van Instinct-GPU’s te danken heeft. Dit is het eigen alternatief voor Nvidia’s H100-chips en ook het aanstormende Blackwell van die rivaal. Momenteel is de Instinct MI300X al grofweg een jaar beschikbaar, de opgevoerde versie (MI325X) net gelanceerd en de MI355X de volgende stap bedoeld voor medio 2025.

Maar daar blijft het niet bij. Norrod vertelt dat er een derde pilaar onder het fundament van AMD te plaatsen is: networking. Dit omdat AI het netwerk op ongekende manieren onder druk zet. En hoewel AMD ook hier een eigen chip te verkopen heeft, is het veel te kortzichtig het daarbij te houden.

Het netwerk moet vloeien

Het probleem voor netwerken is als volgt. Door toedoen van AI zijn de traffic-patronen van workloads compleet veranderd. Front-end netwerken moeten opeens veel meer data aannemen vanuit de buitenwereld dan voorheen, terwijl de gegevens in kwestie regelmatig van een gevoelige aard zijn. Het gaat hierbij om een mengelmoes van downloads, uploads en checkpoints, die allemaal veilig, snel en consistent moeten worden uitgevoerd. Tegelijkertijd moet het back-end netwerk schaalbaar zijn voor duizenden (of zelfs meer dan een miljoen, waarover later meer) GPU’s en ook daar bergen aan data distribueren. Als klap op de vuurpijl zorgen communicatiefoutjes binnen het netwerk voor dubbel werk, waarin nagenoeg dezelfde informatie twee keer wordt verstuurd.

De explosieve toename van AI-workloads vergt daarnaast andere infrastructurele keuzes, waarin een CPU veelal geldt als een dirigent voor een groot aantal GPU’s, ofwel een head node. Daarom kiezen klanten ervoor zoveel mogelijk fysieke serverruimte te geven aan laatstgenoemde. “De druk op CPU’s voor AI-workloads is vaak onderbelicht”, aldus Norrod. En dit zorgt voor problemen, want een overbelaste CPU benut de GPU’s die ervan afhankelijk zijn niet.

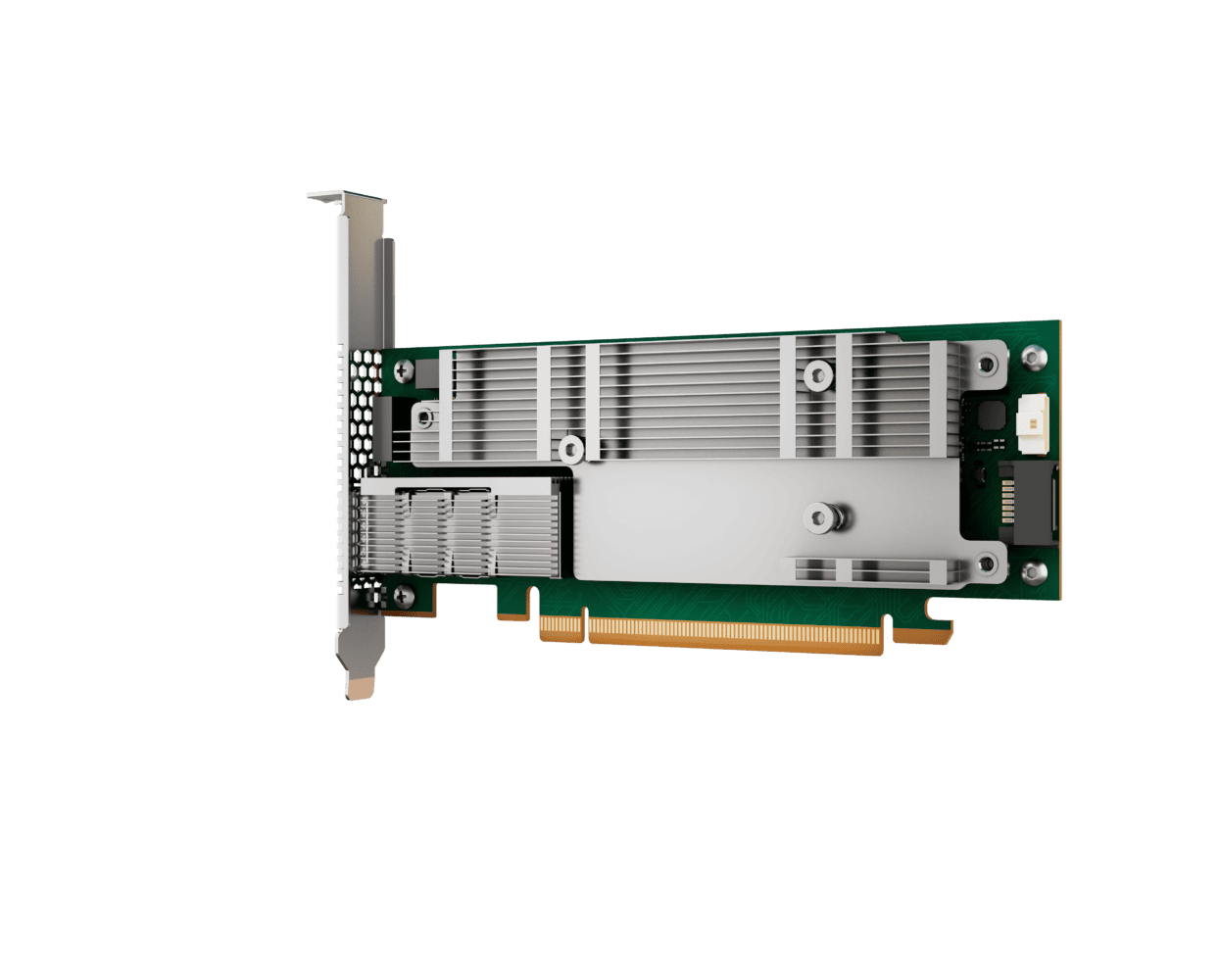

Dit alles betekent dat de CPU ademruimte nodig heeft. Net als dat de grafische kaart ooit ontstond om de CPU te ontzien, is de Data Processing Unit (DPU) tot leven geroepen om dataverwerking te outsourcen naar een discrete chip. Sinds de AMD-overname van Pensando in 2022 zit er een dergelijke DPU in het portfolio, met als fonkelnieuwe versie de Salina 400.

Pensando-portfolio

“Elke packet raakt de DPU”, vertelt Narayan Annamali, GM en Head of Product van Azure Networking bij Microsoft, op het podium van AMD. Hij geeft aan dat de DPU om veel meer dan alleen throughput draait. Het toepassen van security policies is bijvoorbeeld een essentiële functie van de Pensando-chip. Dat vergt een geavanceerd stukje silicium “ontworpen voor hyperscalers”, aldus AMD. Aan boord zitten 232 MPU engines (match processing unit), die connecties en packets regelen. Dit doen ze in plaats van CPU-threads, die vrij zijn gemaakt om ander nuttig werk te verrichten.

Een ander Pensando-product is de Pollara 400, een NIC die het gebruik van het netwerk zelf optimaliseert. Jiandani spreekt over de noodzaak om het back-end netwerk maximaal te benutten. Zo kwam Meta erachter dat het bedrijf bij AI-training 30 procent van de tijd aan het wachten was op het back-end. “Welk uitstel dan ook stopt de voortgang van de GPU’s”, aldus Jiandani. “Hierdoor verlies je extreem waardevolle informatie.” Impliciet: hierdoor verlies je enorm veel geld door een combinatie van uitstel en gebruikskosten. De Pollara 400 moet dit leed zoveel mogelijk voorkomen, en op een slimmere, efficiëntere manier dan zijn voorgangers.

Want wat doet een reguliere NIC? Die voert bij een netwerkfout een fallback uit naar een oud checkpoint en verzendt een heleboel data opnieuw. Om van de huidige 50 procent utilisatie naar 95 procent te gaan én deze redundantie te elimineren, is er meer nodig. De Pollara 400 doet dat op allerlei manieren, van intelligent loadbalancen tot het automatisch omzeilen van opstoppingen ergens in het netwerk. Kortom: terwijl de Salina 400 sneller de verkeerslichten op groen zet voor data, zorgt de Pollara 400 ervoor dat er zo min mogelijk verkeerssituaties ontstaan waarvoor een rood licht überhaupt nodig is.

Tip: Cognizant en Palo Alto Networks bundelen hun krachten

Het oude vertrouwde Ethernet

Dat is uiteindelijk nog in zekere zin een verfijning van een bestaand scenario. Maar om AI te benutten, zijn er wijzigingen nodig aan het datacenter. Meer GPU’s, minder CPU’s. Of, spectaculairder gezegd door Nvidia-CEO Jensen Huang, er lijkt een omwenteling nodig riching “AI-fabrieken” in plaats van conventionele datacenters. Met het eerder genoemde marktaandeel mag je verwachten dat Nvidia hierin sturend kan werken. Heeft de markt daar wel zo’n zin in? En kleven er grote nadelen aan het vasthouden van de bekende keuzes?

AMD formuleert het niet keihard, maar beantwoordt beide vragen indirect met een “nee”. Het is namelijk juist voordelig om voor een optie te kiezen die bestaande infrastructuur alsnog benut, stelt men. Dat is in ieder geval de wens van het Ultra Ethernet Consortium, dat 1,5 jaar geleden werd opgericht. Onder de 97 leden zijn vele techgiganten te vinden, waaronder medestichters AMD, Broadcom, Cisco, Intel en Microsoft. In het eerste kwartaal van 2025 volgt ook een Ultra Ethernet Spec, 1.0, dat precies uitstippelt hoe Ethernet voor AI-workloads optimaal gaat draaien. Overigens is ook Nvidia lid, een frappant feit, want de groep keert zich juist tegen de standaarden van deze GPU-gigant.

Ethernet is volgens het EUC juist het communicatiemedium van de toekomst. Een belangrijk voordeel van Ethernet is dat het al overal zit. In tegenstelling tot InfiniBand, een favoriet van Nvidia voor het aanknopen van GPU’s, is de oude infrastructuur gewoon bruikbaar voor de modernste AI-workloads. “Het is duidelijk dat Ethernet de winnaar is qua schaalbaarheid én prestaties”, vertelt Jiandani. Omdat iedereen een state-of-the-art AI-model traint op een gedistribueerd systeem met talloze GPU’s, is die schaalbaarheid van uiterst belang.

Hoe bereik je die schaalbaarheid? InfiniBand kent een limiet van 48.000 GPU’s. Bij Ethernet is er op te schalen tot voorbij de miljoen “zonder dramatische en zeer complexe workarounds”, aldus AMD. Daarbij doelt het bedrijf op de noodzaak om het netwerk in drie lagen op te bouwen in plaats van twee bij InfiniBand als er meer dan 48.000 GPU’s worden gebruikt. Dit komt door een architecturele keuze. Wel levert Ethernet onder de streep gewoonweg meer latency op tussen GPU’s, waardoor het niet verrassend is dat AMD dit verhaal nauw koppelt aan de Pensando-DPU’s en -NIC’s die dit probleem weer verkleinen. Wat je ervoor terugkrijgt, is de optie om af te stappen van AMD als je liever Intel- of Nvidia-accelerators verlangt.

Keuzevrijheid geven

Dit haakt mooi aan op een breder aspect van AMD’s succesverhaal. Het kan geloofwaardig zeggen dat het klanten keuzevrijheid geeft. Allereerst blijkt dit uit het aanhangen van Ethernet versus het gesloten InfiniBand. Maar we kennen dit al van AMD in andere situaties. Neem Epyc, dat minder vaak van CPU-socket wisselt dan Intel’s Xeon-chips, waardoor upgrades optioneel zijn maar de bestaande infrastructuur bruikbaar houden. Of Ryzen, dat eeuwig op AM4-moederborden bleef (met recent nog een nieuwe release, ook al is AM5 al twee jaar oud) voor consumenten terwijl Intel meerdere sockets versleet.

Die keuzes bestaan dus ook binnen het AMD-portfolio van nu: een Epyc-chip met oersterke, tot 5GHz boostende cores is beschikbaar op hetzelfde platform als een variant met 192 efficiënte Zen 5c-cores. Er is ook geen specifiek voordeel voor klanten die AMD-CPU’s combineren met de eigen GPU’s en/of DPU’s. Het is niet nadelig om een Intel-CPU te combineren met een Nvidia-GPU en AMD-DPU, of welke constellatie ook waarin AMD deelneemt. Alles werkt omdat het van bekende standaarden gebruikmaakt.

De hamvraag is of dit ooit gaat veranderen. AMD’s recente overnames (van Silo AI en vooral ZT Systems) maken dit waarschijnlijker dan voorheen. Het Europese Silo AI is voor het bedrijf een aanwinst qua AI-expertise, mede door de 100+ PhD-houders binnen dat bedrijf. Amerikaanse serverbouwer ZT Systems is een explicietere toevoeging in de richting van full-stack AI-oplossingen, waarin het netwerk een cruciale rol speelt.

Hoe open en traditioneel de Ethernet-situatie dan ook is, als je bij AMD een geheel systeem koopt met alle CPU’s, GPU’s en DPU’s van het bedrijf, is het eindresultaat nog steeds dat je bij een enkele vendor uitkomt zoals ook Nvidia hoopt te realiseren.

Conclusie

Norrod windt geen doekjes om de strategie. Vanzelfsprekend wil een chipmaker chips verkopen. Maar hij benadrukt dat de groei van AMD, zo stevig ingezet na het diepe dal een decennium geleden, nu in een nieuw stadium is beland. Nu het bedrijf gevestigd is als CPU-speler van betekenis en GPU-uitdager, wil het end-to-end AI mogelijk maken zonder anderen op de tenen te trappen. Het heeft bondgenoten nodig om networking op Ethernet te houden voor AI-workloads en InfiniBand weerstand te geven. Dat gaat niet veranderen. Ook is het irreëel om te verwachten dat het bedrijf binnen korte tijd zowel de CPU- als GPU-markt naar zich toe trekt met 50 procent+ marktaandeel. De groei van Epyc, hoe explosief het ook is geweest richting 34 procent, is bijvoorbeeld al aardig afgevlakt doordat bedrijven hun bestaande systemen langer blijven draaien.

Wellicht dat dit verhaal wat minder leuk is voor investeerders. Nvidia belooft telkens snellere AI-chips en levert ze. AMD is op zoveel terreinen aanwezig dat zelfs verbeteringen alom niet dezelfde eenvoud bieden. En dit terwijl AMD stiekem de strategie uitvoert die Intel ambieert, minus het zelf fabriceren van chips.

Desondanks is het bijzonder hoe groot het contrast is tussen AMD anno 2024 en het bedrijf tien jaar geleden. Op servergebied vond de Epyc-opmars eigenlijk pas vijf jaar geleden plaats, dus net ietsje langer dan een verversingscyclus voor datacenterchips (drie à vier jaar). AI dwingt het bedrijf nu om tevens met GPU’s als networking-chips door te pakken. In deze nieuwe situatie benadrukt Norrod dat AMD klanten van keuze wil blijven voorzien. Dat is een grote belofte.

Leestip: Qualcomm’s nieuwste netwerkchip draait lokale AI-workloads