Google heeft een nieuwe versie beschikbaar gemaakt van Open Images, de foto-dataset die helpt bij kunstmatige intelligentie (AI)-projecten. Er komen extra mogelijkheden bij voor het labellen van objecten en een feature die men omschrijft als ‘localized narratives’.

Open Images stelt miljoen foto’s beschikbaar aan data scientists. In de beelden zijn objecten al herkend, waar ook omschrijving aan toegevoegd zijn. Hierdoor kunnen data scientists terugvallen op een grote database, ze kunnen de voorbeelden gebruiken als trainingsdata voor een AI-model met objectdetectie.

De nieuwe versie van Open Images komt met 23,5 miljoen nieuwe ‘foto-level’ labels. Mensen hebben de omschrijving van wat er gebeurt op het beeld geverifieerd. Hierdoor komt het totale aantal labels op 59,9 miljoen. Er zijn ook specifieke annotaties toegevoegd, waaronder 2,5 miljoen labels die menselijke handelingen omschrijven.

Samenhangende annotaties

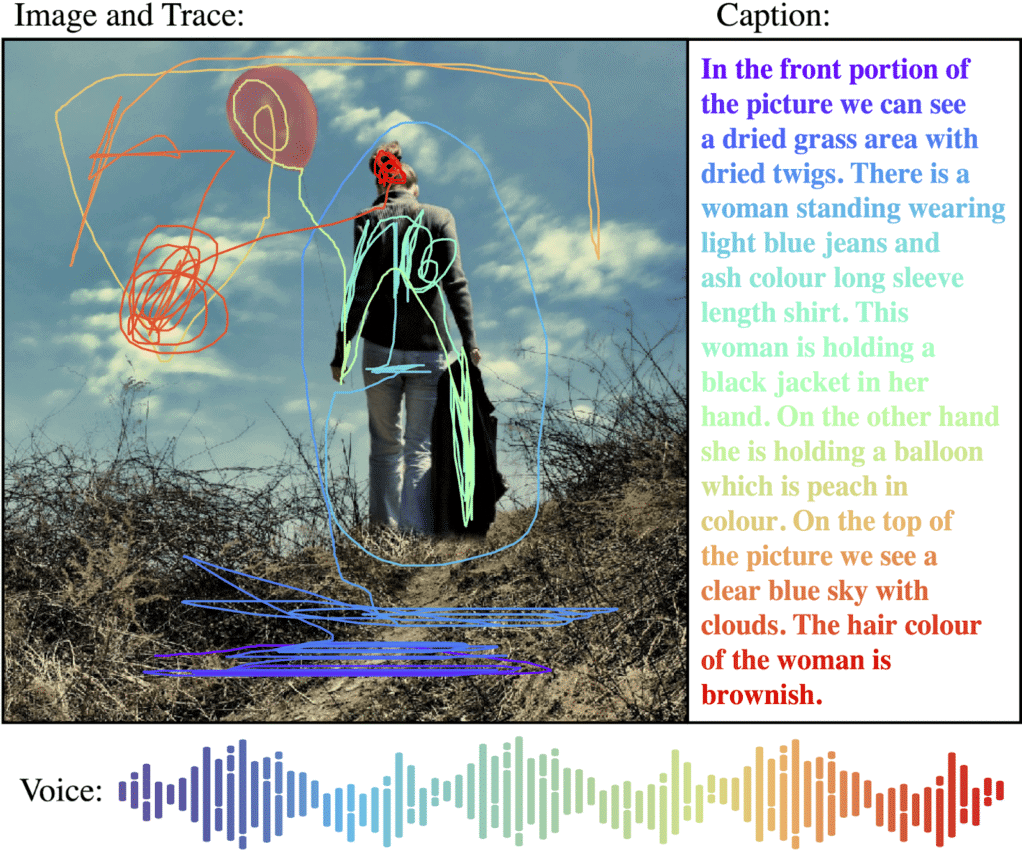

Daarnaast komt de versie met wat Google ‘localized narratives’ noemt. Dit is een nieuw soort annotaties waar modellen meer informatie mee moeten kunnen inwinnen uit een beeld.

Google realiseert de ‘localized narratives’ door een mens objecten te laten selecteren en er een omschrijving aan toe te voegen. Hierbij houdt het systeem de beweging van de muis bij, zodat het precies wet wat er geselecteerd wordt. Dit moet meer samenhang tussen annotaties bewerkstelligen. Op de onderstaande afbeelding, welke Google op zijn blog deelde, is te zien hoe dit precies werkt.

Google heeft ‘localized narratives’ gemaakt voor zo’n 500.000 Open Images-files. Over het algemeen hoopt de techgigant met de update een “kwalitatieve en kwantitatieve stap te zetten richting samenhangende annotaties voor beeldclassificatie en objectdetectie.”