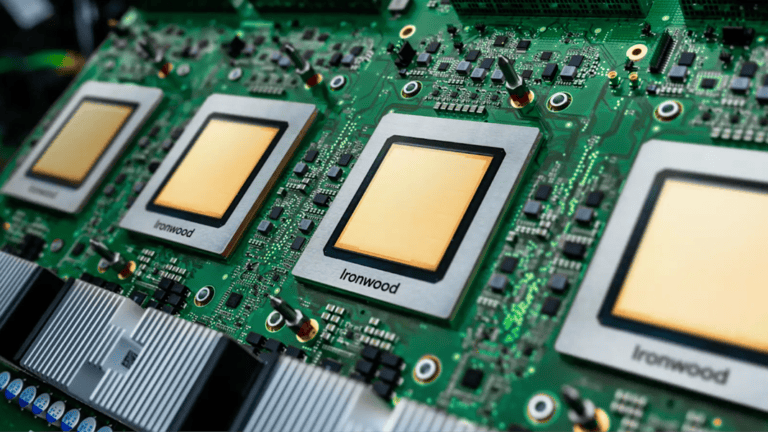

Na een aankondiging in april volgt Google’s lancering van de zevende generatie Tensor Processing Unit (TPU). De chip, voorzien van de codenaam Ironwood, kan opschalen tot bijna 10.000 exemplaren in een enkele pod. Samen met nieuwe Axion-instances op Arm-architectuur belooft het bedrijf grote prestatieverbeteringen. Anthropic wordt een van de eerste gebruikers met maximaal een miljoen TPU’s.

Anthropics toezegging is wellicht het belangrijkste wapenfeit van de lancering van Ironwood. Details over die chip waren tijdens Google Cloud Next in april al grotendeels gedeeld, zoals de verviervoudigde prestaties ten opzichte van de zesde generatie TPU. Anthropic, maker van Claude, krijgt in 2026 meer dan een gigawatt aan capaciteit tot zijn beschikking.

James Bradbury, Head of Compute bij Anthropic, benadrukt dat zowel inference-prestaties als een schaalbare AI-training vereist zijn. De infrastructuur moet daarnaast betrouwbaar blijven. Google rapporteert 99,999 procent uptime voor liquid-cooled systemen sinds 2020. Optical Circuit Switching routeert netwerkverkeer om bij problemen, waardoor workloads doorlopen zonder zichtbare onderbreking.

Ironwood als krachtpatser

Ironwood is speciaal gebouwd voor inferencing. Dat is het daadwerkelijke draaien van getrainde AI-modellen. De focus ligt op snelheid en betrouwbaarheid, cruciaal voor chatbots of coding assistants die snel moeten reageren. Ironwood is dus niet expliciet bedoeld als concurrent voor de krachtigste Nvidia Blackwell GPU’s, die tegenwoordig voor AI-training de favoriete hardware zijn.

Een enkele Ironwood-pod verbindt 9.216 chips met een Inter-Chip Interconnect van 9,6 terabits per seconde. Dit netwerk geeft toegang tot 1,77 petabytes aan High Bandwidth Memory. Volgens Google levert dit 118 keer meer FP8 ExaFLOPS dan de dichtstbijzijnde concurrent. Tegenover voorganger Trillium biedt Ironwood vier keer betere prestaties voor zowel training als inferencing. Dit is bovenop softwarematige verbetering die eindgebruikers in de tussentijd wellicht hebben toegepast.

De hardware komt met nieuwe software. Google Kubernetes Engine krijgt Cluster Director voor onderhoud en topologiebewustzijn. Het open-source MaxText-framework ondersteunt nu geavanceerde trainingstechnieken. De Inference Gateway optimaliseert load balancing, wat time-to-first-token-latency met 96 procent reduceert en servingkosten tot 30 procent verlaagt.

Axion breidt uit met nieuwe instances

Naast Ironwood introduceert Google twee nieuwe Axion-gebaseerde instances. De Arm-gebaseerde CPU richt zich op algemene workloads zoals data-analyse en webserving. N4A-instances bieden tot 64 virtuele CPU’s met 512 gigabyte DDR5-geheugen. C4A metal levert dedicated fysieke servers met 96 vCPU’s en 768 gigabyte geheugen.

Videowebsite Vimeo zag 30 procent betere prestaties voor transcoding-workloads vergeleken met x86-VM’s. ZoomInfo zag een 60 procent verbeterde prijs-prestatieverhouding voor Java-services. Met andere woorden: Axion is niet alleen sneller, maar lijkt ook aanzienlijk voordeliger dan voorgangers.

Dit alles omvat Googles idee van een AI Hypercomputer, feitelijk de optelsom van hardware, software en een verdienmodel om AI-deployment zo eenvoudig en schaalbaar te maken als mogelijk. Google citeert IDC-onderzoek dat een verlaging in de IT-kosten van 28 procent meette en 55 procent efficiëntere IT-teams opleverde. Om dit te realiseren, is er bij Google wel een transformatie aan de gang achter de schermen. Tegenwoordig hanteert het bedrijf 400 volt gelijkstroomlevering voor een megawatt per rack, tien keer zoveel ten opzichte van serverracks in conventionele opstellingen.