Google’s voortgang op het gebied van kunstmatige intelligentie trekt al jaren de aandacht van de internationale media. Met de openstelling van de PaLM-API maakte de techgigant diens large language-model beschikbaar voor ontwikkelaars en eerder deze week werd bekend dat ook Bard er gebruik van gaat maken. Maar wat is PaLM eigenlijk? En hoe verhoudt het zich tot GPT-4, het algoritme achter de AI-chatbot van OpenAI die een wereldwijde hype is geworden?

Als we terug gaan in de historie van PaLM, komen we eerst enkele voorlopers tegen. In 2019 presenteerde Google de integratie van het BERT-algoritme in Google Search. Momenteel verwerkt BERT nagenoeg alle Engelstalige zoekresultaten en is het eveneens actief in 70 andere talen. Het model weet met hoge nauwkeurigheid te voorspellen waar de gebruiker naar op zoek is, onder andere doordat het rekening houdt met de context waarin woorden gebruikt worden.

Sinds de lancering van BERT is de hype rondom AI alleen maar gegroeid. OpenAI, dat een sterke link met Microsoft heeft, gooide hoge ogen met de introductie van ChatGPT. Google kwam niet veel later met een potentiële concurrent van ChatGPT: Google Bard. De resultaten van een gesprek met deze chatbots variëren van diepzinnig tot onzinnig en zijn sterk afhankelijk van het onderwerp en de soort vragen die de gebruiker stelt. Waar ChatGPT gebruikmaakte van OpenAI’s GPT-model, gebruikte Google Bard het zelf ontwikkelde LaMDA. Volgens Google-CEO Sundar Pichai was de verhouding tussen Bard en ChatGPT die van een ‘Honda Civic en een snelle sportwagen’.

GPT-4 en PaLM

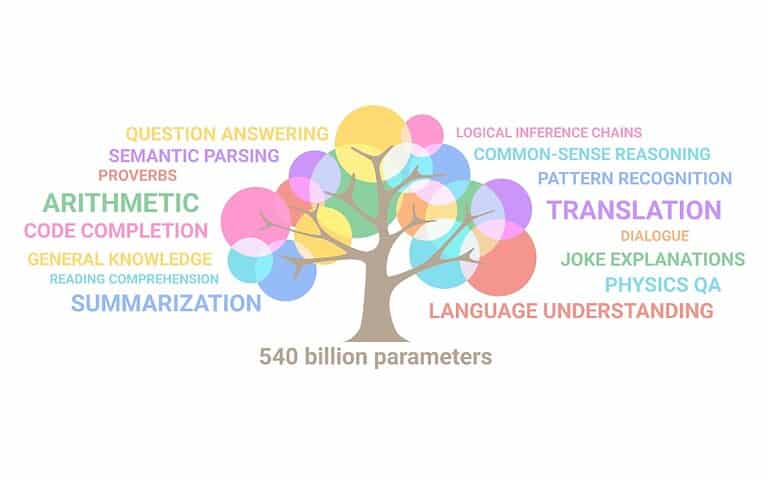

OpenAI heeft echter niet stilgezeten. Recent kwam het nieuwste model van GPT uit, GPT-4. GPT-4 is weer een stevige sprong voorwaarts binnen de wereld van generatieve AI. Google Bard heeft eerder deze week ook een grote update gekregen, met de toevoeging van PaLM (Pathways Language Model). Dit is een model bestaat uit 540 miljard parameters en is getraind op de meest uitgebreide dataset die Google beschikbaar heeft. OpenAI laat zich met GPT-4 officieel niet meer uit over het aantal parameters van diens model. Het zouden er een biljoen zijn, maar daar is in de officiële documentatie niets van terug te vinden. Het is dus moeilijk om de complexiteit van beide modellen op dat gebied te vergelijken.

Zowel GPT-4 als PaLM zijn LLM’s: large language models. Simpel gezegd kunnen dergelijke modellen tekst en andere media genereren, structureren, samenvatten, vertalen of anderszins verwerken op basis van de parameters. De ontwikkeling van een LLM gaat grotendeels om het verfijnen en vergroten van de variabelen. Daarnaast is de data waarop het model getraind wordt cruciaal. Het is enorm tijdrovend om deze dataset op te stellen en te verwerken.

Luister ook eens onze podcast over GPT-4

Doeleinden

Een troef van PaLM is dat het gebruik maakt van Google’s eigen hardware. Duizenden gekoppelde TPU’s (Tensor Processing Units) staan de schaalvergroting toe die PaLM kenmerkt ten opzichte van eerdere modellen van Google zelf. Volgens het bedrijf is één alomvattend AI-model een efficiëntere oplossing dan allerlei kleinere specifieke AI-oplossingen. Het eindresultaat is dat PaLM bijvoorbeeld indrukwekkende resultaten boekt met schoolopdrachten. Rekensommen bedoeld voor 9- tot 12-jarigen lost het model met een succespercentage van 58 procent op, niet ver van de 60 procent die de scholieren gemiddeld scoren.

Een fundamenteel verschil tussen GPT-4 en PaLM is dat alleen PaLM een API beschikbaar heeft voor ontwikkelaars. ChatGPT biedt overigens wel plugins, maar dat is niet hetzelfde. Ironisch genoeg is het product van OpenAI dus niet open-access en PaLM wel. Het toont mogelijk de afwijkende doelstellingen tussen de twee modellen. Daar waar Google allerlei toepassingen van deze vorm van AI mogelijk lijkt te willen maken, is GPT-4 een afgesloten systeem. Toch moeten we dit niet overdrijven. Door de indrukwekkende hardware-eisen hebben zeer weinig ontwikkelaars de capaciteiten om grootschalige oplossingen op basis van PaLM in werking te stellen.

PR-technisch zijn chatbots als Bard en ChatGPT interessant, maar worden diens capaciteiten wel eens overschat. Uiteindelijk ‘denkt’ een chatbot niet, maar voorspelt het achterliggende model slechts welke woorden het moet opdienen. AI-expert Gary Marcus stelde tijdens een podcast-interview met The Economist dat een LLM zeer waarschijnlijk niet het eindstation voor AI gaat zijn. “Het heeft alleen kennis over de verhouding en opvolging van woorden.”

Lees ook: De banen die het meest bedreigd worden door generatieve AI zoals ChatGPT

Toch potentieel

PaLM heeft dus meer overeenkomsten met BERT dan het aanvankelijk lijkt. Toch zijn er voorbeelden van veelbelovende applicaties van LLM’s. Zo heeft Google Med-PaLM geïntroduceerd, waarbij het AI-model is toegepast om medisch advies te geven. Uit onderzoek blijkt dat Med-PaLM een verbetering is ten opzichte van eerdere AI-toepassingen. Een echte dokter is alleen vooralsnog betrouwbaarder. Een succesvolle medische toepassing zou baanbrekend zijn, maar is dus nog niet haalbaar. Is PaLM wellicht beter geschikt als assistent?

Toen Google BERT introduceerde, was het moeilijk om voor te stellen hoe snel de capaciteiten van AI zouden uitbreiden. We zijn in het stadium beland dat mensen als Elon Musk en Steve Wozniak de noodklok luiden. In de AI-wapenwedloop doet Google-CEO Sundar Pichai er goed aan door de capaciteiten van Bard te bagatelliseren. De black box van GPT-4 laat prominente techfiguren zich afvragen of strenge regelgeving rondom AI niet noodzakelijk is. Het positioneren van AI als simpelweg een handige inspiratiebron en assistent is wellicht de meest realistische én politiek haalbare tactiek.